Жидкостное охлаждение в ЦОД: опыт, выводы, перспективы

Тема жидкостного охлаждения в центрах обработки данных все чаще поднимается в связи с растущей удельной тепловой нагрузкой в машинных залах, появлением высокомощных серверов и стремлением сэкономить на эксплуатационных затратах. При этом под жидкостным охлаждением зачастую понимают разные технологии: в одних случаях речь идет о погружном охлаждении, в другом — о подаче теплоносителя непосредственно к вычислительным микросхемам.

Содержание статьи:

Первоначально под жидкостным (или водяным) охлаждением понимали использование системы охлаждения на основе чиллеров, в которой в качестве теплоносителя выступала вода или гликолевые растворы. При этом вода подавалась в кондиционеры, где служила для охлаждения воздуха в помещении. В свою очередь, воздух охлаждал серверное оборудование ЦОД.

Однако с развитием технологий и ростом ИТ-мощностей вода стала в буквальном смысле приближаться к серверам. В одних случаях речь идет о подаче воды по трубкам в непосредственной близости от активных компонентов серверов. В других — микросхемы и вовсе погружаются в специальную ванну, так что происходит непосредственный контакт жидкости и оборудования.

На практике ко всем трем вариантам применяют понятие «жидкостное охлаждение». Об архитектуре этих систем и опыте их реализации и пойдет речь ниже.

Теоретические основы погружного охлаждения

Основным компонентом системы погружного жидкостного охлаждения является некоторое вещество-хладагент, представляющее собой диэлектрический (непроводящий) состав. Как правило, оно содержит белое минеральное масло, благодаря которому его теплоаккумулирующая способность гораздо выше, чем у воздуха при том же объеме. В ИТ-стойке размещается заполненная этим хладагентом ванна, куда серверы устанавливаются вертикально. Хладагент циркулирует по системе и рассеивает выделяемое ИТ-оборудованием тепло.

Несмотря на то что погружение электроники в жидкость с целью охлаждения кажется противоречащим здравому смыслу, такой подход является типичным для охлаждения высоконагруженного оборудования и применяется с 1920-х годов. В частности, многие электрические трансформаторы высокого напряжения, защитные автоматы, конденсаторы и электроподстанции используют жидкостное охлаждение для электроизоляции и рассеивания тепла.

При этом к хладагенту предъявляется ряд специфических требований: низкая вязкость, высокая теплоаккумулирующая способность (теплоемкость), экологичность и нетоксичность. В этом случае использование погружного жидкостного охлаждения дает ряд преимуществ: экономию электроэнергии, повышение производительности, а иногда и снижение капитальных затрат.

Одной из причин, благодаря которой погружное охлаждение обходится дешевле воздушного, является более низкая разница температур между хладагентом и серверами. Другими словами, эффективное охлаждение оборудования оказывается возможным, даже если хладагент нагревается до 40°С, в то время как рабочая температура систем воздушного охлаждения составляет около 24°С. Из опыта эксплуатации холодильной техники известно, что поддержание температуры хладагента на уровне 40°С требует значительно меньших затрат энергии, чем охлаждение воздуха до 24°С (для этого воду в контуре приходится охлаждать до 7–10°С).

Дополнительная экономия достигается за счет удаления серверных вентиляторов, поскольку при погружении оборудования в жидкость необходимость в них отпадает. Это позволяет экономить,в зависимости от вида сервера, еще 10–25% энергии.

Благодаря высокой эффективности системы охлаждения можно выполнять больший объем вычислений при меньших энергозатратах. Фактически система охлаждения оказывается настолько эффективной, что позволяет отводить тепло от серверов общей мощностью до 100 кВт при их размещении в единственной стойке стандартной высотой 42U.

Поскольку система позволяет рассеивать больший объем тепла, чем при использовании воздушного охлаждения, вычислительное оборудование может размещаться плотнее. Как следствие, технология погружного охлаждения наиболее эффективна и полезна в высоконагруженных стойках с блейд-серверами при непрерывном выполнении сложных вычислений.

Среди иных преимуществ погружного жидкостного охлаждения следует отметить следующие:

- Более надежная работа серверов. Серверы перестают собирать пыль. Кроме того, ввиду отказа от вентиляторов отсутствует риск их поломки. Постоянная циркуляция хладагента способствует равномерному распределению температуры по стойке и препятствует возникновению горячих зон.

- Ускоренное восстановление работы серверов после аварийных ситуаций. В отличие от охлаждаемых воздухом серверов, которые после отключения питания воздушных кондиционеров перегреваются в течение нескольких минут, система погружного жидкостного охлаждения может выполнять свои функции от 1 до 4 ч без электричества. Это объясняется высокой теплоемкостью хладагента и, соответственно, увеличенным запасом холода в наполненной хладагентом ванне.

- Снижение внутренних вибраций. Отсутствие вентиляторов значительно снижает уровень вибрации внутри ИТ-оборудования, а ведь, по статистике, до 50% ошибок чтения/записи жестких дисков связаны именно с этим фактором.

- Чистота. Хладагент помогает держать серверы в чистоте благодаря постоянному току жидкости через стойку и насосный модуль. При этом отметим, что, согласно недавним исследованиям, накопление пыли в сервере повышает энергопотребление на 2% вследствие роста рабочей температуры.

Однако у погружного охлаждения имеются и недостатки, прежде всего речь о необходимости применять специальные стойки и модифицировать серверное оборудование. Новый тип стоек обладает большей массой, а потому требования к несущей способности перекрытий возрастают. Кроме того, увеличивается и занимаемая стойкой площадь.

Погружное жидкостное охлаждение на практике

В декабре 2012 года Intel приступила к разработке серверов, рассчитанных на установку в масляной ванне. Погружение компьютера в горячее масло выглядит несколько безрассудной затеей, но специалисты компании убедительно продемонстрировали, что серверы функционируют эффективнее, пока они находятся в таком состоянии.

В частности, для этого было проведено длившееся в течение года тестирование технологии жидкостного охлаждения, во время которого серверы были помещены в специальную серверную стойку, заполненную минеральным маслом. Поскольку масло не проводит ток, короткого замыкания не происходит. Оно циркулирует в емкости и охлаждается в теплообменнике. Как утверждают представители Intel, энергопотребление серверов снизилось на 10–15%, а системы охлаждения — на 90%.

Отметим, что, по словам Майка Паттерсона, старшего архитектора систем питания и охлаждения в Intel, в настоящее время компания исследует ряд радикально новых технологий охлаждения, в том числе другие методы жидкостного охлаждения, стремясь найти способы существенного сокращения энергопотребления. ЦОД являются крупными потребителями энергии, что существенно сказывается на стоимости их эксплуатации. В некоторых случаях компаниям даже не хватает подведенной мощности для обеспечения питания и качественного охлаждения оборудования.

Специалистам Intel настолько нравится технология погружного охлаждения, что в настоящее время они всерьез рассматривают идею разработки специальных серверов. Созданные для погружного охлаждения серверы будут снабжены специальными радиаторами, рассчитанными на жидкостное (вместо воздушного) охлаждение, лишены вентиляторов и оснащены SSD.

«Первые клиенты организованной три года назад компании применяют погружное охлаждение не только для повышения энергоэффективности, но и в целях повышения надежности компонентов, — поясняет Энди Прайс, руководитель по бизнес-разработкам компании Intel. — Поскольку некоторые процессоры, включая GPU, чрезмерно нагреваются, процент их выхода из строя слишком высок. Поместив серверы в минеральное масло, можно снизить температуру, при которой они функционируют. При этом срок возврата инвестиций для центра высокопроизводительных вычислений, как правило, составляет менее двух лет».

Пример системы погружного охлаждения серверов

Одним из практических воплощений системы погружного жидкостного охлаждения является система CarnotJet компании Green Revolution Cooling. Она представляет собой комплексную систему, в которой для достижения максимально эффективного охлаждения вместо воздуха применяется непроводящий жидкий хладагент. По заявлению производителей, в сравнении со стандартной серверной стойкой, охлаждаемой воздухом, CarnotJet позволяет снизить энергопотребление системы охлаждения типичного ЦОД на 90–95%, а также сократить общее энергопотребление в два раза.

В системе используется хладагент GreenDEF — это прозрачное, нетоксичное и не имеющее запаха недорогое диэлектрическое (непроводящее) минеральное масло, специально приспособленное для охлаждения серверов и другого оборудования ЦОД.

Строительство центров обработки данных, оснащенных системами CarnotJet, обходится операторам ЦОД дешевле традиционных решений, поскольку система погружного жидкостного охлаждения позволяет снизить среднее и пиковое энергопотребление, а значительная часть затрат на расширение ЦОД связана именно с высоким пиковым энергопотреблением.

Система CarnotJet включает в себя три основных модуля: стойка, насосный модуль и модуль контроля и управления.

Стойка CarnotJet напоминает традиционную стойку, рассчитанную на воздушное охлаждение. Разница в том, что серверы устанавливаются вертикально, а не горизонтально и полностью погружаются в непроводящий хладагент. Типовая стойка 42U занимает площадь 1,2 м2 и весит около 1500 кг при полной загрузке (см. Рисунок 1). Хотя такой стойке нужно больше места по сравнению с традиционным шкафом, оснащенным воздушным охлаждением, но изоляции холодных и горячих зон не требуется. Таким образом, ей необходима примерно такая же площадь, что и традиционному серверному шкафу.

Рисунок 1. Восемь серверных стоек системы CarnotJet, установленных на фальшпол.

Охлаждение горячей водой

Еще одним интересным решением в области жидкостного охлаждения, которое, к слову, хорошо вписывается в рамки современной тенденции повышения температуры в машинных залах ЦОД, является система охлаждения горячей водой, предложенная компанией IBM. Ее применение для охлаждения суперкомпьютера Leibniz SuperMUC позволило сократить энергопотребление на 40%.

При проектировании суперкомпьютерных систем в расчет берется не только фактор производительности. Сокращение энергопотребления является одной из наиболее сложных технических проблем на пути к созданию мощных и быстрых суперкомпьютеров.

Как сообщают представители Leibniz Supercomputing Centre (LRZ), их новый суперкомпьютер SuperMUC (см. Рисунок 2) (MUC в названии соответствует коду расположенного неподалеку Мюнхенского аэропорта), построенный в сотрудничестве с IBM, потребляет на 40% меньше энергии, чем его аналоги. Существенная экономия достигается за счет использования технологии водяного охлаждения, которую IBM применяет с целью создания компьютерных систем с высокой плотностью размещения оборудования.

Рисунок 2. Новый суперкомпьютер SuperMUC.

Установленная в LRZ система направляет нагретую суперкомпьютером воду в теплообменник. В холодное время года вода используется для отопления здания. Согласно оценке, это позволит ежегодно экономить около 1 млн евро.

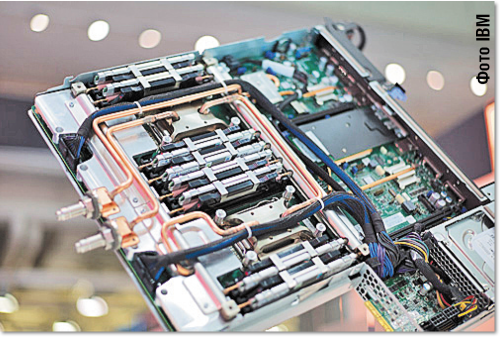

Технология компьютерного охлаждения под названием Aquasar была разработана в исследовательской лаборатории IBM в Цюрихе. Небольшие трубы, названные микроканалами, доставляют воду непосредственно к серверным процессорам, а после охлаждения она рециркулируется для повторного отвода тепла (см. Рисунок 3).

Рисунок 3. Серверная система охлаждения x iDataPlex dx360 M4 компании IBM.

Технологии управления энергопотреблением и пиковой производительностью приобретают все большую значимость по мере того, как происходит рост плотности размещения вычислительных систем. За счет своей энергоэффективной конструкции SuperMUC оказался в 10 раз более компактным и имеет более высокую пиковую производительность, чем аналогичные системы с воздушным охлаждением, сообщают представители Leibniz Supercomputing Centre.Как сообщил профессор Боде, руководитель Суперкомпьютерного центра им. Лейбница, благодаря уникальной схеме прямого водяного охлаждения энергоэффективность SuperMUC оказалась чрезвычайно высокой. Процессоры и оперативная память остужаются теплой водой, поэтому создавать дополнительную охлаждающую инфраструктуру не надо. Данная схема была разработана IBM специально для SuperMUC. Использование процессоров Intel и новейшего программного обеспечения позволяет еще больше сократить энергопотребление.

IBM рассчитывает, что применение горячего водяного охлаждения станет стандартом для суперкомпьютеров будущего, в том числе для трехмерных процессорных архитектур, предполагающих размещение процессоров друг над другом. По сообщению IBM Research, исследователи работают над созданием крошечных труб диаметром 50 мкм, которые можно будет располагать между процессорами. Согласно прогнозам IBM, к 2025 году размер суперкомпьютера может уменьшиться до величины обычного настольного ПК образца 2012 года — и это только за счет использования водяного охлаждения.

Варианта охлаждения горячей водой придерживаются и в компании «РСК Технологии». В построенном ею центре обработке данных «РСК Торнадо» горячая вода из стоек поступает непосредственно в чиллер без промежуточных звеньев — кондиционеров, теплообменников и др. Предварительно создается трехмерная модель микросхемы, на основе которой формируется система алюминиевых каналов, по которым и протекает теплоноситель.

Как результат, все тепло, генерируемое сервером, передается теплоносителю, а во внешнюю среду (за пределы сервера, в помещение) оно не поступает. Это означает, что охлаждения воздуха в машинном зале ЦОД не требуется.

Особенностью разработки компании «РСК Технологии» является расширяемость решения. Совокупность сервера и алюминиевой пластины с каналами рассматривается как масштабируемый модуль. На его основе с необходимой инженерной обвязкой строится микроЦОД, занимающий несколько юнитов в одной стойке, мини-ЦОД, состоящий из одной или двух стоек, или полноценный ЦОД, где предусмотрен целый ряд ИТ-стоек.

Водяное охлаждение

Под лозунгом использования «зеленых» технологий для охлаждения ЦОД в 2012 году было проведено несколько экспериментов с использованием воды и масла, цель которых заключалась в обеспечении максимально эффективной работы серверов.

Интересный вариант водяного охлаждения реализован во многих центрах обработки данных компании Google. В принадлежащих Google ЦОД серверное помещение представляет собой единый холодный коридор (см. Рисунок 4). Фальшпол не снабжается вентиляционными решетками. Весь процесс охлаждения происходит внутри закрытых горячих зон (коридоров), которые располагаются между рядами серверных стоек. Охладители с холодной водой служат «потолком» для данных участков, внутри которых проложены толстые трубы в стальной оплетке — по ним подается вода из градирен, расположенных за пределами здания.

Рисунок 4. Серверное помещение центра обработки данных Google в Mayes County, штат Оклахома, где установлены высокоэффективные серверы компании.

Вентиляторы, расположенные в задней части стоек, направляют его в закрытые зоны, где температура достигает 50°С. Здесь горячий воздух поднимается вверх и проходит через охладители («охлаждающие катушки»), в результате чего его температура снижается до требуемых 26,5°С. Затем воздух выбрасывается через верхнюю часть горячих зон (коридоров). Гибкие трубы, проведенные под фальшполом, соединяются с охлаждающими катушками, расположенными в верхней части горячего участка.

Несмотря на длительную историю применения систем водяного охлаждения, которые использовались еще в мейнфремах IBM, некоторые операторы современных ЦОД до сих пор опасаются близкого подведения водяных труб к серверам и устройствам хранения. Многие производители встраиваемых систем охлаждения, предназначенных для установки между рядами стоек, предлагают на выбор использование охлажденной воды либо хладагента.

Однако Джо Кава, старший директор подразделения центров обработки данных Google, вполне доволен подходом Google: используемая схема включает в себя систему обнаружения протечек и систему обеспечения отказоустойчивости на случай выхода труб из строя. «Если в охладителе возникнет течь, вода будет капать вниз и уходить под фальшпол», — объясняет Кава. Он согласен с тем, что небольшое отверстие в трубке или разрыв катушки могут доставить немало хлопот, но отмечает, что его компания достаточно давно использует данную схему охлаждения и серьезных инцидентов пока не было.

Заключение

Все больше и больше компаний принимают участие в разработке новых эффективных решений по охлаждению как высоконагруженных, так и обычных серверов. Intel, IBM и другие компании проводят различные эксперименты по внедрению систем жидкостного охлаждения, пытаясь выработать эффективную и максимально простую в применении концепцию отвода тепла от серверов.

Безусловно, сдерживающими факторами являются инерционность рынка и необходимость адаптации ИТ-оборудования к потребностям инженерных систем, однако растущий багаж опыта и накопленных знаний поможет преодолеть рубеж перехода от воздушного к жидкостному охлаждению.

«www.AboutDC.ru – Решения для ЦОД». Статья опубликована в журнале LAN, №4, 2013г.

Дополнительные материалы

Оставить комментарий